Trong chương 4 này chúng ta sẽ nghiên cứu một số kỹ thuật về SEO thông qua 9 bài học này. Mỗi một bài học sẽ giúp chúng ta hiểu sâu hơn về cơ chế hoạt động của bộ máy tìm kiếm. Đây cũng là bước khá quan trọng trong việc xếp thứ hạng trên công cụ tìm kiếm. Bạn cũng cần phải hiểu công cụ tìm kiếm index site bạn như thế nào, cách nó cập nhật nội dung mới ra sao. Để từ đó ta sẽ có được những chiến lược SEO tốt nhất. Tránh được những sai lầm không đáng có .

Sau đây là 9 bài học nói về các kỹ thuật trong SEO:

Vì sao cần nghiên cứu các yếu tố kỹ thuật trong SEO

Một cách lý tưởng, các máy tìm kiếm có thể tìm ra và hiểu mọi loại nội dung ở bất kỳ đâu trên thế giới web và trả về những kết quả liên quan nhất đến cụm từ tìm kiếm của bạn. Tuy nhiên, xây dựng website là một quá trình phức tạp và không tránh khỏi những thiếu sót. Một vài lỗi thậm chí có thể khiến máy tìm kiếm không tìm ra được website của bạn, hoặc khiến nó không thể có thứ hạng tốt.

Để trở thành một người làm SEO giỏi, bạn cần phải biết cách hoạt động của máy tìm kiếm, cách nó tìm ra nội dung mới, cách nó hiểu và xếp hạng trang web của bạn. Điều này sẽ giúp bạn nâng cao chất lượng website hiện có và tránh mắc phải những lỗi mà mọi người thường hay mắc phải.

Để tham khảo về cơ chế hoạt động các bạn đọc bài viết :

Cách Google thu thập và lưu trữ dữ liệu

Bằng cách tạo ra các con bọ tìm kiếm hay còn được gọi với những cái tên như “Bots”, “Spiders” có nhiệm vụ chính là thu thập các dữ liệu (hay crawl) của tất cả các website. Khi một con Bots thu thập dữ liệu của một website, chúng đồng thời sẽ di chuyển theo các đường link có trên trên các website đó để tìm ra các website mới. Những đường link này có thể là các link nội bộ, hoặc link trỏ ra ngoài. Nhờ đó bọ tìm kiếm có thể khám phá và thu thập tất cả các nội dung trên trang web đó, cũng như nội dung của các website khác.

Trong quá trình các spiders crawl dữ liệu của một bài hoặc website, chúng sẽ đồng thời phân loại và sắp xếp dữ liệu vào các “khay” tương ứng trong bộ nhớ của Google dựa theo các thuộc tính như: nhân khẩu học, lĩnh vụ, chủ đề, địa điểm,… quá trình này được gọi là Google Index.

Khi một người dùng thực hiện hành động nhập truy vấn tìm kiếm trên Google. Lập tức bộ máy tìm kiếm sẽ dựa theo các thuộc tính như địa điểm, chủ đề, ý định,… của truy vấn đó, đối chiếu với những dữ liệu mà Google Bot thu thập được và trả lại các kết quả có các thuộc tính trùng khớp nhất với truy vấn của người dùng trên SERP.

Mã trạng thái HTTP

Các mã trạng thái giống như các biển báo có nhiệm vụ báo hiệu cho những con bọ tìm kiếm biết được trang web có thể được thu thập hay không?

Để hiểu rõ hơn thì khi các bots của các máy tìm kiếm truy cập vào website, máy chủ web sẽ trả về một số thông tin, trong đó có mã trạng thái. Thông tin này cung cấp cho bọ tìm kiếm biết nó có thể tiếp tục truy cập vào website hay không, nếu có thì xử lý nội dung trên website như thế nào.

Các mã trạng thái phổ biến thường gặp gồm:

- Mã 200: Mọi thứ đều ổn, các spider có thể tiến vào dò quét và lưu trữ nội dung trang web.

- Mã 301: Trang web đã được di chuyển vĩnh viễn tới một địa chỉ mới. Các Bots và người dùng truy cập bằng địa chỉ cũ sẽ được chuyển hướng tự động sang địa chị mới. Ngoài ra sức mạnh mà địa chỉ cũ sở hữu như số lượng liên kết trỏ đến, thứ hạng từ khóa trên Google,… đều sẽ được chuyển giao hoàn toàn sang địa chỉ mới.

- Mã 302: Trang web được di chuyển tạm thời đến vị trí mới. Bọ tìm kiếm cũng như người dùng sẽ được đưa tới trang web mới. Máy tìm kiếm không cần gỡ bỏ trang web này khỏi CSDL, đồng thời giá trị của link vẫn được dành cho trang web cũ.

- Mã 404: Trang hiện không còn tồn tại, không thể truy cập do một lỗi nào đó. Máy tìm kiếm sẽ xóa trang web khỏi CSDL và người dùng sẽ nhận được một trang 404 nếu truy cập vào trang web này.

- Mã 500: Có lỗi máy chủ, cả bọ tìm kiếm và người dùng đều không thể truy cập vào trang web.

- Mã 503: Trang web tạm thời không phục vụ. Người dùng và bọ tìm kiếm nên quay lại sau. Mã 503 rất hay được dùng trong giai đoạn bảo trì website.

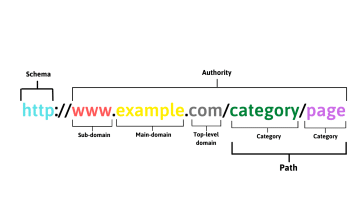

Cấu trúc URL và cách tối ưu

Cấu trúc cơ bản của một URL gồm:

Checklist tối ưu URL chuẩn SEO:

- URL không nên đặt quá dài, tốt nhất chỉ nên trong khoảng 75 ký tự đổ lại.

- URL không chứa dấu và ký tự đặc biêt.

- URL phải chứa từ khóa chính.

- URL không nên chứa quá nhiều thư mục con (category): chỉ nên đặt chứa từ 1-2 category hoặc tốt nhất không nên đặt category trong URL.

Trùng lặp nội dung trên website

Trùng lặp nội dung là điều thường gặp ở các website.Trùng lặp nội dung xảy ra khi 2 trang web khác nhau có nội dung giống nhau.

Nguyên nhân phổ biến gây trùng lặp nội dung:

- Sử dụng liên kết tương đối cùng với subdomain. Hậu quả: Trùng lặp giữa subdomain và domain chính

- Sử dụng liên kết tương đối cùng với https. Hậu quả : Trùng lặp giữa phiên bản http và https

- Trùng lặp thẻ Tag

- Trùng lặp Category

Hướng giải quyết:

- Redirections bài trùng lặp về một URL duy nhất

- Đổi với những bài chất lượng kém bạn có thể xem xét xóa bỏ chúng đi

Tốc độ tải trang

Một trong các yếu tố có mức độ lớn đến chất lượng của website được Google đề cao chính là tốc độ phản hồi của một website. Tốc độ phản hồi của một website gây ảnh hưởng trực tiếp đến tương tác trải nghiệm của người dùng với website. Bạn có thể check tốc độ tải trang của trang web tại đây:

https://developers.google.com/speed/docs/insights/EnableCompression?hl=vi

Site map & RSS Feeds

Sitemap là một trong những yêu cầu bắt buộc website phải có. Các sitemap có tác dụng khai báo và chỉ đường cho các google bot di chuyển và crawl dữ liệu trên website của bạn.

Một số cách tạo sitemap cho website:

- Đối với các website được xây dựng trên mã nguồn wordpress, bạn có thể sử dụng các plugin hỗ trợ tự động tạo và khai báo sitemap cho website như Rank Math hoặc Yoast SEO.

- Đối với các website được code tay, bắt buộc bạn phải nhờ đến sự giúp đỡ của bộ phận coder để tạo sitemap và phải tự mình khai báo trên Google Search Console.

Một số lỗi thường gặp với sitemap:

- Sitemap lỗi khiến không thể khai báo Sitemap trên Search Console

- Website không được tạo Sitemap

- Tạo Sitemap nhưng không khai báo trên Google Search Console

Những lỗi kỹ thuật thường gặp trong SEO

Một số lỗi kỹ thuật thường gặp trong SEO hay gặp phải:

- Chặn Google Bot trong file robots.txt

- Lỗi đặt thẻ Canonical

- Lỗi chuyển hướng hướng 301

- Lỗi website không có sitemap

- Sitemap chưa được khai báo

- Website không có chứng chỉ SSL

- Website chưa được tối ưu tốc độ load

- …

Những tools SEO cần thiết

- Google Chrome (Inspect Feature): Trình duyệt này là công cụ đắc lực trong việc kiểm tra mã nguồn của trang web. Để sử dụng, click chuột phải lên trang web (khi bạn đang sử dụng Chrome) và chọn “Kiểm tra phần tử (inspect element)

- Firebug: Chức năng tương tự như tính năng “Kiểm tra phần tử” của Chrome, nhưng là một trình cắm (plugin) cho FireFox

- SEObook Toolbar: Đây là một trình cắm FireFox, có rất nhiều chức năng bao gồm:

- Làm nổi bật/đánh đấu các thành phần trên trang giúp bạn kiểm tra nhanh và dễ dàng

- Xem cache/ngày tạo cache

- Xem Page Rank

- SEOmoz Toolbar: Đây là trình cắm có thể cài trên cả FireFox và Chrome cho ban biết điểm uy tín của cả domain cũng như từng trang web (domain and page authority), đồng thời cho phép bạn truy cập nhanh đến bộ tool SEO đầy đủ của MOZ. Toolbar cũng tự động cung cấp cho bạn các thông số về link trên bảng kết quả tìm kiếm.

- Bộ chuyển đổi User Agent: Đây là trình cắm cho FireFox và Chrome cho phép bạn đặt user agent của bạn là Googlebot

- Web Developer Toolbar: Đây là một toolbar cài trên FireFox cho phép bạn bật/tắt JavaScript, xem và chỉnh sửa cookies, bật/tắt CSS, hiển thị/chỉnh sửa thông tin của các thành phần trên trang.

- Screaming Frog: Đây là chương trình phần mềm có chức năng dò quét website và báo cáo dữ liệu về tất cả các trang đã dò bao gồm: mã trạng thái HTTP, liên kết trên trang, kích thước và tiêu đề trang. Chương trình có cả phiên bản miễn phí và trả tiền.

- Xenu: Chương trình này tương tự như Screaming Frog nhưng ít chức năng hơn

- Microsoft IIS SEO toolkit: Một công cụ dò quét khác cung cấp nhiều dữ liệu hữu ích: ví dụ số lượt click để đến một trang web.

Các Tài liệu tham khảo khác:

– Phương pháp tìm kiếm website chuẩn seo

Xem tiếp ⇒ Chương 5: Interactive robots.txt

Tìm hiểu thêm các cách làm khác hoặc tham khảo khóa học seo chuyên nghiệp của VietMoz để được hệ thống hóa các kiến thức một cách bài bản.

Nguồn: www.vietmoz.edu.vn

Bản quyền thuộc về Đào tạo SEO VietMoz

Vui lòng không copy khi chưa được sự đồng ý của tác giả